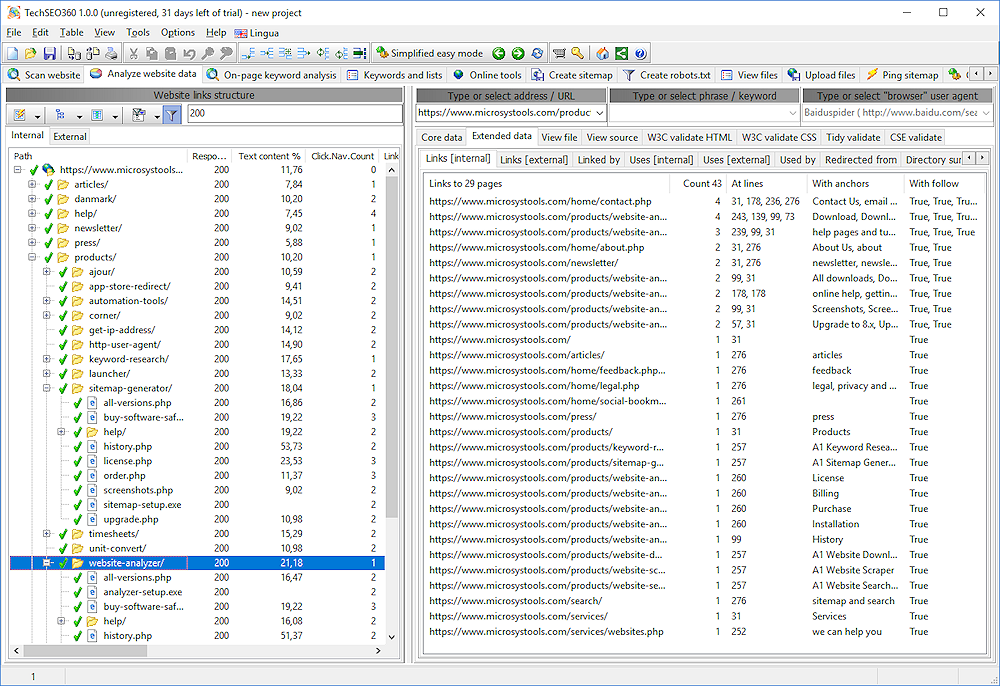

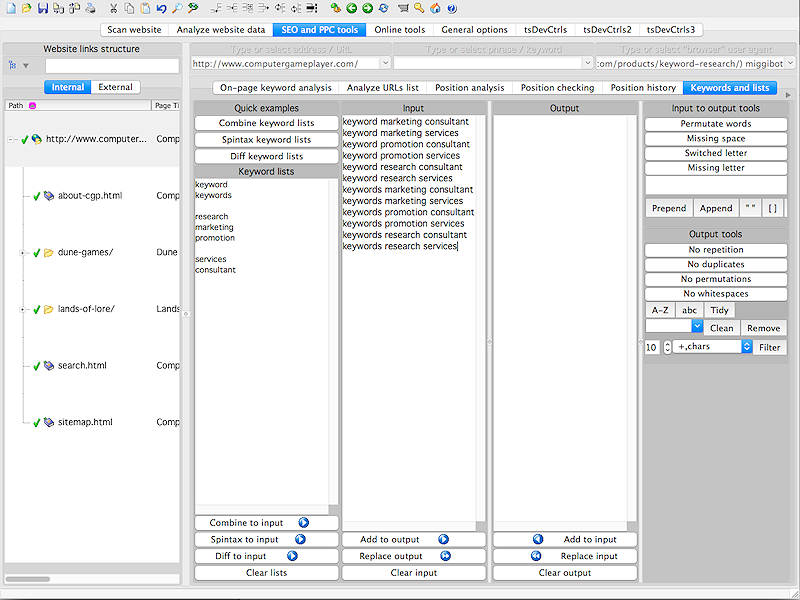

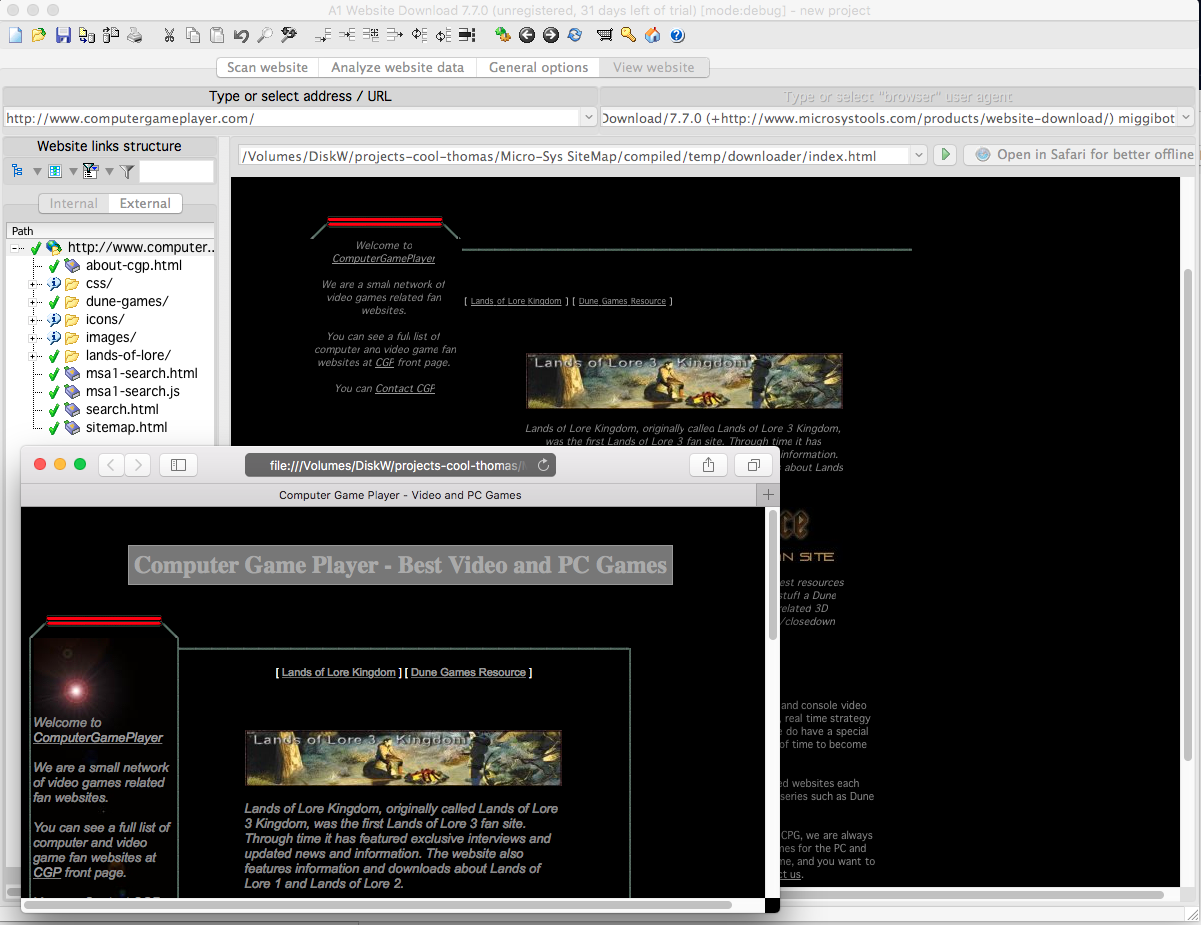

Komplett sökrobotverktyg för SEO-webbsidor, inklusive innehåll, interna länkar och brutna referenser. Kan också skapa alla typer av webbplatskartor, inklusive XML med hreflang, video, bild, RSS / ROR, text, anpassad HTML / CSS / Javascript, DOT för visualiseringsgrafer och mer. Ingen bestämd övre gräns för antal webbadresser på webbplatsen - praktisk gräns beror men vanligtvis mellan 100 000 och 1 000 000 sidor. Lätt att filtrera skanningsresultat, visa och exportera valda data till CSV och liknande verktyg. Crawler-motorn kan vara mycket konfigurerad att följa anpassade regler för vilka sidor som ska genomsökas och vilka webbadresser som ska inkluderas i resultat. Stödjer schemaläggning via ett rikt kommandoradsgränssnitt.

Vad är nytt i den här utgåvan:

Version 1.0.5 kan innehålla ospecificerade uppdateringar, förbättringar eller buggfixar.

Begränsningar :

30-dagars prov

Kommentarer hittades inte